今回は論文の紹介です。

Bootstrap法の開発者として有名な統計学の巨人,Bradley Efron, による Prediction, Estimation, and Attribution というperspective的な論文。Journal of the American Statistical Associationからオープンアクセスで全文読めます。

つい先日軽い気持ちで開いた論文です(タイトル地味だし)。抄録だけで済ますつもりがのめり込んでしまい、ページをめくる手が止まらなくなりました。Efron先生は82歳にしていまだsharp。

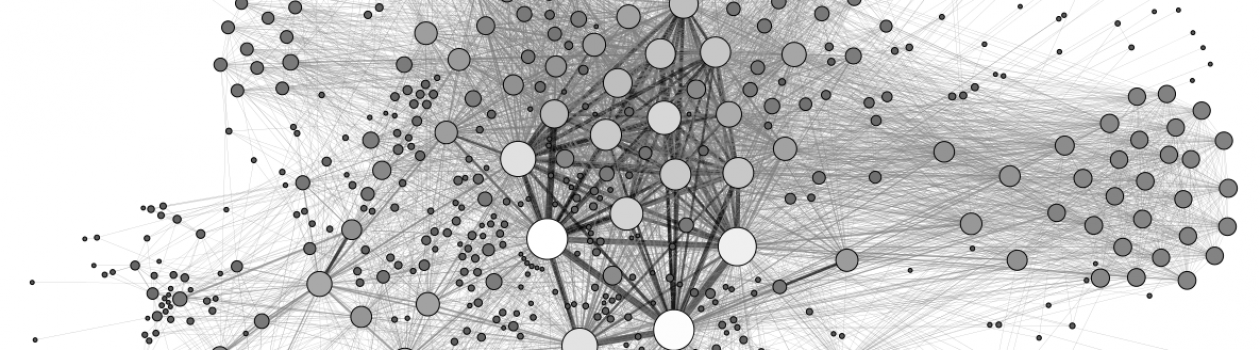

基本的な内容は、traditional regression methodsとpure prediction algorithms (boostingやrandom forestsなど)における目的、仮定、そしてphilosophicalな違いについて。彼のスタンスがよくわかります。Table 5には6つの項目を挙げて両者の違いをまとめています。

機械学習アルゴリズムについてのテクニカルな部分は簡単に触れているだけなので、これは読み飛ばすか、興味があればHastieらによる”The Elements of Statistical Learning: Data Mining, Inference, and Prediction”あたりを参照すれば良いと思います。

印象に残ったのは(統計学も含めて)サイエンスの追い求めるものについての彼なりの回答の提示。フェローの先生方にはこれこそ実体験とともに腑に落ちてくれればなあと思っています(個人的な願望)。研究目的は十人十色でよいのですが、少なくとも僕はこれに突き動かされて研究をしているので。

いくつか引用します:

– “Science, historically, has been the search for the underlying truths that govern our universe: truths that are supposed to be eternal.” ““Short-term science” is an oxymoron.”(Efronはcontext-dependentな、または応用的な研究領域にケンカ売っている?)

– 古典的統計学については、“In the absence of genius-level insight, statistical estimation theory … share(s) the goal of extracting dependable scientific structure in a noisy environment. The noise is ephemeral but the structure, hopefully, is eternal, or at least long-lasting.”

– 予測アルゴリズムについては、“Without the need to model surface or noise mechanisms, scientific truth fades in importance on the prediction side of the table. There may not be any underlying truth.” ”In short, we do not have an optimality theory for prediction”

いろいろと手厳しいですが、その上で両者の歩み寄りのトレンドと未来も示しています。読者の立ち位置によって賛否両論あるでしょうが(そもそも研究の目的が違うので)、それも含めて一読の価値がありそうです。

1件のコメント